| | | Je vous demande de vous arrêter ! | Cher(e) toi, Alors ça y est ? On y est ? On va VRAIMENT tous mourir et cette fois à cause de l’intelligence artificielle ? Enfin, plutôt à cause de ChatGPT puisqu’il faut bien nommer le diable de l’histoire ? C’est ce que suggère une tribune proposée par un groupe de pensée américain méconnu et soutenue par Elon Musk. Faire une pause de 6 mois dans le déploiement de l’intelligence artificielle. Faire une pause, qui peut être contre ? Alors je vais te proposer un nouvel adage : faire une pause c’est bien, prendre du recul c’est mieux. Et tu vas voir que cette légère différence d’approche peut nous amener sur des territoires très surprenants. Viens, je t’emmène avec moi au pays magique de la prise de recul. ❤️ Avant de commencer, si tu ne me connais pas, je me présente : je suis Benoît Raphaël, co-fondateur de Flint. Et chaque dimanche, je réfléchis avec toi sur la façon dont nous pouvons parvenir à penser par nous-mêmes dans le chaos de l'info. D'ailleurs, si on t'a fait passer cette lettre,tu peux t'abonner ici.

|

Dans cette édition, je te propose une analyse assez longue sur le débat autour de l'IA mais qui te donnera, je l'espère des clés pour comprendre ce qui est en jeu. Et je te propose de venir me voir le 20 avril pour la sortie de mon livre, attention, les places pour l'apéro sont limitées à 60 ! ❤️

|

|

Ce pays est voisin d’un autre pays qui s’appelle le pays “Oulalah”. Au pays Oulalah on dit tout le temps “oulalah”, parfois on y ajoute “ça fait peur !”. Et en général, dès que l’on dit “ça fait peur”, tous nos neurones se dressent en même temps parce que, l’être humain étant relativement fragile, c’est peut-être bien celui qui a le plus dit “oulalah ça fait peur” qui a le mieux réussi à survivre. Mais je te propose de passer ce préalable complètement silmpliste pour aller un peu plus loin. Passons la frontière du pays des Oulalah, et allons voir du côté du peuple des “Hahaaa”.

Le peuple des “Hahaaa” a tendance à se prendre le menton dans la main et à réfléchir à toutes les implications d’une idée avant de prendre une décision. Il n’est pas en guerre avec les Oulalah, il n’entre jamais en guerre d’ailleurs. Et il est aussi très copain avec le peuple des “Waouuuuh” qui, pour le coup, a beaucoup moins de chances de survie que les Oulalah parce qu’il est toujours content et enthousiaste. En revanche, les Hahaaa doivent en permanence résister à ces deux envahisseurs qui se massent à leurs frontières.

| Tiens, je t’ai mis tout ça sur un joli dessin : | | Cette petite géographie mise en place, je te propose de découper le problème en plusieurs étapes.

|

Tout d’abord, les faits. Bon. Tu as dû noter toute cette folie, cette semaine, autour des IA génératives comme ChatGPT, Bard (Google), mais aussi Midjourney (tu sais, la photo du pape en doudoune qui n’était pas vraie), sans compter l'Italie qui a décidé de bannir tout ce bordel. Bref tu t'es sans doute dit comme moi que ça allait un peu trop vite. Nous sommes à un vrai moment “Oulalah”.

|

Au pays des Oulalah, cette semaine, une tribune signée par un millier de personnes dont un certain nombre de personnalités comme l’entrepreneur Elon Musk, l’historien Yuval Noah Harari et le co-fondateur d’Apple Steve Wosniak, a fait grand bruit. Les signataires appellent à faire une pause de 6 mois dans le développement d’intelligences artificielles plus puissantes que GPT-4. C’est à dire le dernier modèle derrière ChatGPT, l’IA générative la plus connue de l’histoire de l’humanité.

|

Que dit ce texte ? Voici la tribune originale. Et voici une synthèse (résumé par ChatGPT qui n’en a rien à foutre et n’a pas compris qu’on parlait de lui, tu noteras) …

|

Les systèmes d'IA avec une intelligence compétitive humaine présentent des risques importants pour la société et l'humanité, comme le montrent des recherches approfondies et reconnues par les principaux laboratoires d'IA. Malgré les dangers, les laboratoires d'IA se livrent à une course incontrôlée pour développer des intelligences numériques de plus en plus puissantes et incontrôlables. Nous devons nous interroger sur l'impact de l'IA sur nos vies, notamment en termes de désinformation, d'automatisation et de perte de contrôle de notre civilisation. Les auteurs appellent à une pause immédiate d'au moins 6 mois dans l'entraînement de systèmes d'IA plus puissants que GPT-4, avec la participation de tous les acteurs clés. Cette pause doit être utilisée pour élaborer et mettre en œuvre des protocoles de sécurité partagés pour la conception et le développement de l'IA avancée, ainsi que pour accélérer le développement de systèmes de gouvernance solides en collaboration avec les décideurs politiques. L'objectif est de profiter d'un "été de l'IA" en récoltant les bénéfices des systèmes d'IA actuels, en les rendant plus sûrs et bénéfiques pour tous, et en laissant à la société le temps de s'adapter, au lieu de se précipiter sans préparation vers des conséquences potentiellement désastreuses. |

Tu es d’accord avec ce texte, je suppose. Faire une pause c’est bien. Réfléchir collectivement à notre avenir aussi. Et en bon “Oulalah”, je rajouterai : si on pouvait le faire, collectivement, sur l’ensemble des problèmes qui menacent l’avenir de l’humanité (comme le dérèglement climatique, la course à l’armement nucléaire, la possibilité que nous avons de créer des virus en laboratoire, la manipulation génétique, la concentration des moyens technologiques et économiques entre quelques mains, la spéculation financière incontrôlée… je m’arrête là ?) ça serait bien aussi.

Même si ce n’est visiblement pas comme ça que ça marche. Le monde n’est pas une classe de neige ni un séminaire d’entreprise où l’on brainstorme en riant à coup de post-it et de jeux de “team bulding”. Du coup, quand on lit une tribune comme celle-ci, il est intéressant de franchir la frontière du pays des Oulalah pour aller voir notre petit village des “Hahaaa”. Qui a écrit ça ? Quels sont les enjeux politiques derrière ? De quoi parle-t-on vraiment ?

|

Avant d’y aller, je te propose une photo prise en secret du célèbre village irréductible des Hahaaa. Photo entièrement fausse et prise par une IA… Sympathiques non ? | | Bien.

|

Pour faire cet exercice, je te propose d’écouter les scientifiques qui n’ont pas signé ce texte. Que disent-ils ?

|

Commençons par OpenAI. Les créateurs de ChatGPT reconnaissent que "à un certain moment, il peut être important d'obtenir un examen indépendant avant de commencer à entraîner de futurs systèmes”. Leur texte, un peu ambigu (ok pour réfléchir ensemble mais pas ok pour dévoiler nos méthodes) est d’ailleurs cité dans la tribune.

| Plus intéressant, ces deux chercheurs de Princeton, Sayash Kapoor et Arvind Narayanan. Que disent-ils ?

|

“Nous sommes d'accord que la désinformation, l'impact sur le travail et la sécurité sont trois des principaux risques de l'IA. Malheureusement, dans chaque cas, la lettre présente un risque spéculatif et futuriste, ignorant la version du problème qui nuit déjà aux gens. Elle détourne l'attention des véritables enjeux et rend leur résolution plus difficile. La lettre adopte une mentalité de confinement analogue au risque nucléaire, mais cela ne convient pas bien à l'IA. Elle sert directement les intérêts des entreprises qu'elle cherche à réglementer.” |

Hahaaa… qu’est-ce que ça veut dire ?

|

Ça veut dire que pour résoudre les problèmes il faut d’abord bien identifier... le problème. Méthode que l’empire des Oulalah a un peu du mal à maitriser. Tu vas voir, explorer cette idée va t’aider à mieux faire face aux questions à se poser quand tu as le sentiment que, comme en ce momentk, ça va beaucoup trop vite. |

Les deux chercheurs proposent de différencer deux méthodes d’analyse des risques.

La méthode spéculative (qui est la méthode préférée des Oulalah), et la méthode réaliste (privilégiée par les “Hahaaa”).

| (Ci-dessous, une vue rarissime de la ville des Oulalah lors de leur grand rassemblement annuel : ) | |

La première méthode essaie d’imaginer l’avenir en spéculant, dans une approche assez similaire à la science-fiction. Ce n’est peut-être pas inutile, notamment pour le long terme, mais ça ne correspond pas forcément à la réalité du moment. Avec le risque de renforcer les fantasmes tout en ignorant les vrais problèmes de fond.

|

La seconde méthode, est plus pragmatique, elle propose d’analyser les risques réels et à court terme. Tu me diras qu’il faut sans doute un peu des deux. Je te laisse y réfléchir. Mais voici un exemple sur les trois problèmes évoqués dans la tribune, prenons celui des fake news :

|

Méthode Oulalah :

Oulalah, GROS risque de désinformation malicieuse générée par l’IA !

Méthode Hahaaa :

Hahaaa, le vrai risque n’est-il pas dans la confiance démesurée que l’on porte à ces outils dits d'IA qui ne sont justement pas de l'IA à proprement parler ? |

|

Les auteurs font remarquer que le fait, pour la tribune, d’évoquer une IA “trop puissante” contribue à alimenter cette confiance dans ces grands modèles de langage qui ne sont pas techniquement intelligents, mais impressionnants dans leurs résultats.

|

Mais la contradiction la plus intéressante est apporté par Emily Bender. Qui est elle ? Emily Bender est professeure de linguistique informatique à l’Université de Washington et sorcière en chef du village des Hahaaa. Certains d’ailleurs la trouvent un peu trop extrême, parce que, vois-tu, il y a AUSSI des courants de pensée dans le village des Hahaaa vu qu’ils adorent polémiquer entre eux, mais passons… Son approche est d’autant plus pertinente qu’elle est à l’origine des travaux de recherche sur lesquels s’appuie précisement la tribune pour argumenter son propos.

| Voici une photo d’Emily réinventée par l’IA de Midjourney (tu noteras un truc bizarre avec ses lunettes, typique du style inimitable des IA) : | | Que dit Emily Bender ?

|

Tout d’abord, elle nous donne un peu de contexte. Qui est derrière cette tribune ? Comme diraient les journalistes du Point : Qui sont-ils ? Quels sont leurs réseaux ?

Alors ils viennent d’un autre village, qui est plutôt une sorte de citadelle un peu comme celle de Saroumane dans le seigneur des anneaux, que l’on appelle la citadelle des “long-termistes”.

| Précisons pour commencer qu’Elon Musk n’a jamais beaucoup aimé l’IA. Il "la" soupçonne de “vouloir” (hum), à terme, remplacer l’humanité. Sa solution à lui : développer des implants pour augmenter l’humain avec de l’IA. Sur ce point, son entreprise, Neuralink, n’a pas l’intention de faire de pause. En revanche, elle a pris beaucoup de retard sur ses premiers tests sur des humains qu'elle prévoyait de faire cette année. D'où peut-être son agacement. Mais revenons à notre citadelle “long-termiste” (et non pas “long termite”, même si les termites font aussi des citadelles)…

| |

Celui qui en parle le mieux, peut-être, c’est Émile Torres, professeur de philosophie à l’université Leibniz de Hanovre (Allemagne). Ancien adepte du “long-termisme” (il a même écrit un livre sur le sujet), il évoque cette mouvance de manière assez négative. Comme leur nom l'indique, les long-termistes pensent l’avenir l’humanité à l’échelle de plusieurs millions d’années. Le mouvement compte parmi ses pionniers l’Américain Nick Bostrom, auteur d’un livre sur l’intelligence artificielle ("Superintelligence"). Il est le fondateur du “Future of Humanity Institute”. Or il se trouve qu’Elon Musk, écrit Torres, a financé cet institut à hauteur d’1,5M$ par le biais de l’organisation “Future of Life”. Une association créée par l’entrepreneur et milliardaire Jaan Tallin, co-fondateur de Skype. Pour te donner un apperçu du personnage, Tallin estime par exemple que le dérèglement climatique ne consitue pas un risque existentiel pour l’humanité, mais un truc que l’on peut gérer. Non, pour lui, le vrai risque existentiel, c’est l’avénement de cette super intelligence dont tout le monde parle (même OpenAI) depuis des années sans trop savoir comment on peut y arriver. Un mouvement dans lequel on retrouve également un autre milliardaire, proche de Donald Trump, Peter Thiel. Tu noteras que ces deux milliardaires, Musk et Thiel, étaient à l’origine de la création d’OpenAI, dont ils s’écartent aujourd’hui, considérant désormais (je résume à mort) l’entreprise comme un dangereux repère de “wokistes” (c’est à dire des progressistes un peu radicaux) (je résume grossièrement aussi).

|

C’est cette association, Future of Life, qui est à l’origine de la tribune dont tout le monde parle. C'est elle qui réclame une pause de 6 mois dans le développement de modèles plus performants que GPT-4.

|

Comme tu le vois, cette histoire est plus politique qu’il n’y parait.

| Voici ce qu'en dit Émile Torres :

| “Le long-termisme pourrait être l'une des idéologies les plus influentes dont peu de gens, en dehors des universités d'élite et de la Silicon Valley, ont entendu parler”. Le dogme central du long-termisme est le suivant : “rien n'est plus important, d'un point de vue éthique, que la réalisation de notre potentiel en tant qu'espèce de vie intelligente originaire de la Terre”. Cela veut dire, explique encore l’auteur, que, “si l'on adopte une vision cosmique de la situation, même une catastrophe climatique qui réduirait la population humaine de 75 % au cours des deux prochains millénaires ne serait, dans le grand ordre des choses, qu'un petit incident - l'équivalent d'un homme de 90 ans qui se serait cogné l'orteil à l'âge de deux ans.” |

|

Dans cette perspective très inspirée de la science-fiction, notamment celle d’Isaac Asimov (l'auteur de "Fondation" et du "cycle des robots"), le seul risque existentiel c’est que l’IA remplace l’humanité. Le reste n'est que détail.

| Ça te parait un peu déconnecté de la réalité ? Voire un peu, disons… mystique ? Oui.

C’est peut-être un délire de milliardaires. Tout comme celui de l'immortalité.

| Voilà pour le socle politico-mystique de cette tribune.

|

C’est peut-être pour cela que Yann LeCun, patron de la recherche en IA de Facebook (qui trouve aussi que ChatGPT n’a rien de révolutionnaire), évoque l’Eglise lorsqu’il critique cette tribune (qu’il a refusé de signer) . Sur Twitter, le chercheur rappelle que l'église avait aussi demandé une pause à l'époque de l'invention de l'imprimerie, pour éviter que la société soit détruite. |

“Nous sommes en 1440 et l'Église catholique a demandé un moratoire de six mois sur l'utilisation de la presse à imprimer et des caractères mobiles. Imaginez ce qui pourrait arriver si les roturiers avaient accès aux livres ! Ils pourraient lire la Bible eux-mêmes et la société serait détruite.” | |

L’analogie est peut-être bizarre, tu me diras, mais si l’on essaie de suivre sa réflexion, on comprend que s’il compare l’IA actuelle à l’imprimerie, c’est parce qu’elle n’est rien d’autre, à ses yeux, qu’une machine, dont la potentielle toxicité (ou bienfaisance) dépend de l’usage que l’on en fait.

|

Et c’est là que nous revenons à Emily Bender. Que dit-elle ?

| Elle dit qu’elle n’est pas contre l’idée d’une prise de recul. Elle remet surtout en question le fantasme qu’entretient la tribune sur “une intelligence compétitive avec l'homme” pouvant “présenter des risques profonds pour la société et l'humanité”. D'autant plus que cette affirmation s’appuie sur un texte de recherche qu’elle a co-écrit début 2021. Ce texte s'appelle : “ Sur les dangers des perroquets stochastiques : Les modèles linguistiques peuvent-ils être trop grands ? 🦜” (l’émoji est bien dans le titre de l’article !). |

Dans cet article, précise-t-elle, “il n'est pas question d'hypothétiques "systèmes d'IA dotés d'une intelligence compétitive avec celle des humains". Nous parlons de grands modèles de langage.”

| |

Pourquoi dit-elle ça ? Parce que tout son propos depuis 2021 consiste à dire que les grands modèles de langage ne sont pas intelligents, ce sont des perroquets stochastiques. Et que c'est parce qu'ils sont très cons qu'ils sont potentiellement dangereux.

Qu’est-ce que ça veut dire ? "Stochastic parrot" est un terme utilisé pour décrire les modèles de langage, tels que GPT-3 ou 4 qui génèrent du texte de manière probabiliste en se basant sur les données d'entraînement qu'ils ont apprises. Le terme "stochastique" fait référence au processus aléatoire par lequel le modèle sélectionne les mots pour générer du texte, tandis que "perroquet" fait référence à la façon dont le modèle répète les informations et les structures linguistiques présentes dans les données d'entraînement sans avoir une véritable compréhension du sens des mots ou du contexte. En résumé, comme dirait notre ami ChatGPT, les modèles de langage avancés sont donc principalement des outils statistiques qui imitent la génération de texte humain, plutôt que de véritables intelligences capables de comprendre et de raisonner sur le langage de manière similaire à un être humain. Qu’est-ce qu’il faut comprendre ? Qu’avec les grands modèles de langage on reste assez loin de ce qu’on appelle intelligence artificielle (au sens de la conférence fondatrice de 1956 qui en “inventa” le terme).

Il s’agit plutôt d’une machine qui recrache du savoir humain avec une part aléatoire. Quand la machine ne se trompe pas et qu’elle est bien utilisée, le résultat peut être très impressionnant et utile (produire une analyse pertinente par exemple, détecter des failles, ou résoudre des tâches intellectuelles), mais cela reste un outil. C'est un outil qui, comme l’a été Internet, n'a rien de neutre : il embarque les biais de ses données d'apprentissage et de ses concepteurs. Et il peut être utilisé de façon malveillante ou irresponsable.

Un outil puissant mais faillible qui, connecté à la complexité des usages et d’Internet, peut être à l'origine d'émergences, c'est à dire d'événements imprévisibles. D'où la crainte de nombreux spécialistes. Au cœur de tout ça, depuis le début de cette histoire, c’est donc bien l’usage qui est en jeu. Plus que la technologie en elle-même.

|

Répétons-le encore une fois, pour bien retenir la leçon : les grands modèles de langage comme GPT-4 ne sont pas des intelligences. Mais des super calculatrices capables de produire du texte et de l’analyse, de facon suffisamment aléatoire pour qu’elles se trompent dans 30-40% des cas. Elles ne s’améliorent que grâce à une surcouche d’entraînement qui les bride petit à petit dans leurs réponses, et orientent artificiellement leurs résultats en leur imposant une "bonne manière" de réagir.

Ces calculatrices linguistiques n’apprennent pas, ne te reconnaissent pas, ne se souviennnent pas de ce qu’elles t’ont dit en dehors de la fenêtre de conversation. D’ailleurs, elles ne sont pas précisément des calculatrices parce qu’elles ne savent pas vraiment calculer !

|

Cependant, la réflexion d’Emily Bender a une limite : ces perroquets ne sont pas que des perroquets qui enchainent des réponses statistiques et reproduisent les biais dans les données qu'ils ont mémorisé. Enfin, plus seulement. Depuis un an, des chercheurs s’intéressent à la capacité qu’ont ces grands modèles à “raisonner”. Comment ? Par le biais des instructions (qu'on appelle "prompts") qu’on leur donne. Si le résultat généré par ChatGPT dépend du contexte donné par le prompt, cela signifie qu’il peut être orienté, guidé. Et notamment orienté à travers un modèle de raisonnement. On appelle ça “ la chaîne de pensées”.  De quoi s’agit-il ?

De quoi s’agit-il ? Il s’agit de demander à ChatGPT (ou à ses amis) de découper une question qui lui est posée, comme par exemple la résolution d’un problème, en une ou plusieurs étapes de sous-questions. Le robot continue de produire un résultat statistique (on appelle ça un modèle auto-regressif parce qu'il est basé sur ses propres valeurs passées, d'où le risque d'erreurs), mais il le fait cette fois par étapes, en suivant le contexte de raisonnement qu’on lui impose. Ce n’est donc pas lui qui raisonne, mais le contexte d’instructions. Cependant, le résultat est là. GPT-4 par exemple (qui inclut probablement ces modèles dans sa surchouche d’entrainement) découpe désormais ses réponses en étapes pour résoudre des problèmes complexes. |

On n’est toujours pas dans l’intelligence à proprement parler, mais dans une imitation qui permet cependant à ChatGPT de produire des analyses, de faire en quelque sorte des “déductions” (même si le terme est inaproprié puisqu’un humain le guide dans l’exercice), ce qui peut lui permettre, au vu de l’immense base de connaissance dans laquelle il vient puiser, de surpasser les humains dans certaines tâches intellectuelles. Ou en tout cas de leur faire gagner du temps. Voire de pointer des questions ou des angles morts auxquels ils n’avaient pas pensé. C’est ce que suggère le créateur de GPT-4, Ilya Sutskever, lorsqu’il affirme que ces modèles ont une " compréhension profonde de la réalité sous-jacente", parce qu’ils ont absorbé toute la connaissance textuelle (donc biaisée) du monde. Ce qui signifie, estime-t-il, qu’ils peuvent potentiellement résoudre des problèmes sans même en avoir vu la réponse.

|

On est donc bien, comme tu peux le comprendre maintenant, toujours face à une sorte d’instrument probabiliste. Mais un instrument qui, lorsqu’il chevauche la pensée humaine (via les prompts qu’on lui soumet) a la possibilité d’aiguiser son analyse et de produire des textes plus pertinents. A condition de bien maitriser l’art du prompt. Et en gardant à l’esprit la capacité qu’ont ces modèles à se tromper, dans 2 à 3 cas sur 10.

| Voilà !

C’était long, je sais, mais il était important, je pense, de poser une bonne fois pour toute ces principes, pour que tu puisses t’y référer dès que tu seras tenté de rejoindre le pays des Oulalah.

| Que conclure de tout cela ? |

|

Que le vrai risque n’est pas tant dans l’émergence d’une intelligence qui remplacerait les humains, cette intelligence n’existe pas (pas encore me diras-tu, ok), mais dans les usages malveillants ou inconsients d’une technologie puissante en laquelle il ne faut d’ailleurs pas trop avoir confiance (vu sa dimension probabiliste et aléatoire). Que le Oulalahisme n’est pas une philosophie. Mais que parmi les Oulalah se cachent des idéologies et des intérêts politiques, voire géopolitiques, qu’il convient de bien cerner avant de crier au loup... avec les loups. Qu’en se focalisant sur les risques (bien réels on est d’accord, notamment en terme de cybersécurité) on oublie un peu facilement les bienfaits que ces technologies peuvent apporter, lorsqu’elles sont bien maitrisées (c’est à dire en ayant conscience de leurs limites et leurs risques) : en matière d’aide à l’expertise, de science, d’ingénierie, de médecine, d’information (oui, aussi) et même d’esprit critique. Que ChatGPT est un outil "pré-entrainé" pas une intelligence, mais que tu peux obtenir des résultats plus intelligents en apprenant à l'utiliser. Que la question de la transparence est clé. Comme celle de la concentration de ces pouvoirs dans des entreprises privées. |

Et, hum, histoire de te perturber un peu avec un point de vue trèèèèès "oulalah", je te laisse avec cette vidéo de Geoffrey Hinton. Hinton est un chercheur canadien spécialiste de l'intelligence artificielle et plus particulièrement des réseaux de neurones artificiels.

Lauréat du prix Turing, et ancien prof de Yann LeCun, il fait partie de l'équipe Google Brain et est professeur au département d'informatique de l'Université de Toronto. C'est donc un personnage très sérieux. Que dit-il ? Eh bien il flippe un peu...

| Hinton : "C'est un problème, n'est-ce pas. Nous devons réfléchir sérieusement à la manière de le contrôler."

Journaliste : "Le pouvons-nous ?"

Hinton : "Nous ne savons pas. Nous n'en sommes pas encore là. Mais nous pouvons essayer !"

Journaliste : "Cela semble plutôt inquiétant, non ?"

Hinton : "Euh, oui !" |

Oulalah ! |

| |

| | | | Participe à l'apéro de lancement de mon livre et rencontrons-nous !

eventbrite.fr - 1 avr. |  | | Ça y est ! Mon premier livre est à l'impression. C'est le résultat d'un gros travail d'enquête et de réflexion sur le chaos de l'info qui nous attend et sur comment y faire face sans perdre les pédales. J'y parle ChatGPT, biais cognitifs, fatigue informationnelle, et je propose même quelques pistes pour faire du bien à ton cerveau. Viens prendre un verre avec moi pour découvrir "Information : l'indigestion - Penser par soi-même dans le chaos de l'info", à la librairie Eyrolles (mon éditeur), le 20 avril à 18h à Paris. Attention, les places sont limitées à 60 personnes, et comme vous êtes plus de 20.000 à recevoir cette lettre, je te conseille de réserver maintenant (clique sur le titre) ! Au plaisir de te rencontrer en vrai ! |

| | |

| | | | 🇬🇧 IA : catalyseur d'une révolution économique ou menace pour notre avenir ?

technologyreview.com - 25 mar. |  | | L'intelligence artificielle (IA) pourrait-elle déclencher une révolution économique et technologique sans précédent ? David Rotman explore cette question dans un article fascinant. Alors que des modèles IA tels que ChatGPT se développent rapidement, leur impact sur la productivité, l'emploi et la création de richesse reste incertain. Certains économistes, comme Erik Brynjolfsson, sont optimistes quant à l'utilisation de l'IA pour stimuler la créativité et la croissance économique. D'autres, comme Daron Acemoglu et Simon Johnson, mettent en garde contre les dangers potentiels de l'automatisation et de la concentration du pouvoir entre les mains de quelques grandes entreprises technologiques.

Rotman souligne que les modèles de langage génératif comme ChatGPT ont déjà montré leur potentiel dans divers domaines, tels que la chimie et la recherche scientifique. Cependant, la manière dont ces outils seront utilisés et déployés dépendra en grande partie des décisions prises par les entreprises, les gouvernements et les individus. Diane Coyle, économiste à l'Université de Cambridge, plaide pour la création d'une organisation internationale de recherche publique sur l'IA, à l'image du CERN, pour diversifier les incitations et les visions des créateurs de modèles IA.

En fin de compte, l'avenir de l'IA dépendra des choix que nous faisons en tant que société. Brynjolfsson insiste sur le fait que "nous pouvons avoir l'une des meilleures décennies de tous les temps si nous utilisons la technologie dans la bonne direction", mais il prévient que ce n'est pas inévitable. Ainsi, le débat sur la manière d'orienter les progrès de l'IA pour servir au mieux l'intérêt général reste plus que jamais d'actualité. |

| | |

| | | 🇬🇧 La jeune fille à la perle, créée par une IA, a remplacé le tableau original

instagram.com - 29 mar. |  | | L'idée est venue lorsqu'une exposition majeure sur Vermeer au Rijksmuseum d'Amsterdam a laissé la place de "La Jeune Fille à la perle" vide pendant quelques mois au musée Mauritshuis. Le musée a alors lancé le projet @mygirlwithapearl, où chacun pouvait envoyer sa propre version du célèbre tableau sous différentes formes.

L'artiste Julian Ai Art (à la base un photographe) a soumis sa version réalisée avec l'IA de MidJourney et Photoshop. Sur 3 500 images envoyées, 175 ont été choisies.

L'utilisation de l'IA par Julian Ai Art vise à soulever la question des possibilités offertes par la technologie actuelle et de ses implications. Bien qu'admiratif du travail de Vermeer, il ne cherche pas à le remplacer et ne pense pas que cela puisse être fait avec une quelconque technologie. Sa réflexion porte sur la manière dont les nouveaux outils d'IA pourraient changer les processus créatifs |

| | |

| | | Et, hum, donc cher(e) ami(e), j'en profite pour te remettre encore une fois ma pub ici (oui oui je sais désolé encore une fois si tu es déjà au courant mais bon c'est ma lettre, je fais ce que je veux !) | |

L'objectif de cette formation Flint : t'offrir toutes les clés pour devenir un expert de ChatGPT, l'intelligence artificielle dont tout le monde parle (et sur laquelle on a dit un peu tout et n'importe quoi) et t'aider à maîtriser cet outil incroyablement puissant (mais plein de pièges). |

|

Si tu n'as pas encore essayé la formation (mise à jour pour GPT-4), je te propose d'y accéder avec une réduction de 35%. Il reste encore 12 places. |

| Et si tu n'as pas les moyens de te la payer, si tu es au chômage ou étudiant(e) par exemple, envoie moi un mail, je te ferai une proposition. J'aimerais que cette formation soit utile au plus grand nombre. |

| |

| |

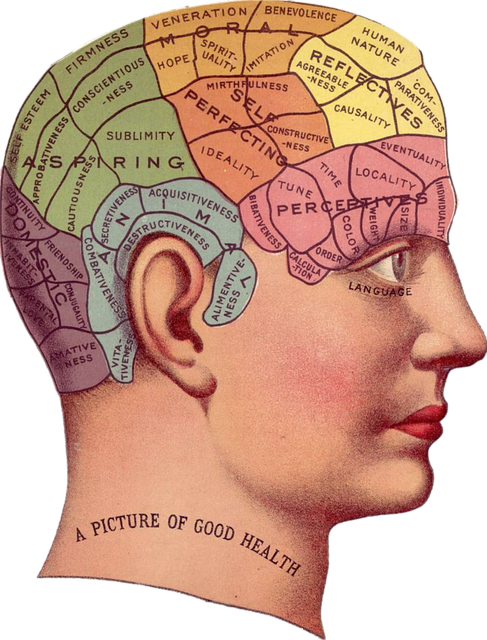

| | | | Le cerveau comme champ de bataille dans la guerre économique

ege.fr - 28 mar. |  | | Cet article très documenté traite de la manière dont les entreprises et les acteurs économiques utilisent les neurosciences et les sciences cognitives pour influencer l'opinion publique, notamment dans le but de contrer une déstabilisation et de protéger leurs intérêts. Les auteurs analysent les méthodes de discréditation de la science et de manipulation de l'opinion publique en s'appuyant sur des exemples concrets, tels que l'industrie du tabac. Les biais cognitifs, ces failles de notre pensée, sont exploités par ces acteurs pour semer le doute et orienter les comportements. La guerre cognitive, dans laquelle l'esprit devient un champ de bataille contesté, est présentée comme une stratégie essentielle pour le secteur privé. Les investissements dans les neurosciences sont en augmentation, et le domaine cognitif est considéré comme le champ de bataille de demain. |

| | |

| | | | Dilemme : quand les journalistes reconnaissent leurs erreurs, les lecteurs comprennent mieux mais ont moins confiance

niemanlab.org - 27 mar. |  | | Une nouvelle étude montre que les corrections d'articles journalistiques augmentent la précision de l'information, mais réduisent la confiance du public. L'étude, menée par le News Co/Lab et des chercheurs de Dartmouth College, a examiné l'effet des corrections sur la compréhension et la confiance du public. Les participants ont lu un fil Twitter avec un faux tweet, puis un second fil contenant soit une correction du tweet, soit une correction d'un tiers, les deux corrections ou aucune. Les résultats ont montré que les participants ayant vu une correction avaient une meilleure compréhension des faits, mais moins confiance dans la source de l'information. Personnellement, je n'ai jamais eu ces résultats, ça dépend sans doute de la façon de reconnaitre ces erreurs. Et notamment de faire de la transparence et de la conversation une culture. Si le lien est fort avec ton audience, reconnaitre ses erreurs est aussi un moyen de faire de la pédagogie. |

| | |

| | | | Esprit critique et autonomie intellectuelle

afis.org - 27 mar. |  | | L'article souligne le rôle essentiel de l'esprit critique et de l'autonomie intellectuelle pour naviguer dans un monde d'informations diverses. Inspiré par les philosophes Bertrand Russell et Emmanuel Kant, il met en garde contre la tentation de l'autarcie intellectuelle et prône un juste équilibre entre la confiance accordée aux sources d'information et la vigilance face à la manipulation. L'esprit critique ne consiste pas à rejeter systématiquement toute information provenant d'autrui, mais à analyser et évaluer ces informations pour se forger un jugement éclairé et indépendant. |

| | |

| | | | 🧐 ESPRIT CRITIQUE ES-TU LÀ ? | | |

| | | Logically, l'entreprise qui traque la désinformation

logically.ai - 29 mar. |  | | La mission de Logically consiste à combiner l'intelligence artificielle et des analystes experts pour lutter contre les contenus nuisibles et manipulateurs à grande échelle et rapidement. L'entreprise œuvre pour réduire les dommages individuels, institutionnels et sociétaux causés par les discours trompeurs et fallacieux en ligne.

Depuis sa création en 2017, Logically dit intercepter les menaces avant qu'elles ne se propagent largement.

Son équipe internationale est composée de data scientists, ingénieurs, analystes, développeurs et enquêteurs.

Tu peux télécharger leur rapport sur l'activité de désinformation russe en février dernier (ainsi que d'autres documents, enquêtes et analyses). |

| | |

| | | | 🙈 DES NOUVELLES DE SAPIENS | | |

| | | Comment l'IA pourrait modifier notre jugement et notre prise de décision

axios.com - 25 mar. |  | | Des psychologues et des scientifiques du comportement commencent à étudier l'impact de l'utilisation de générateurs de texte et d'images à intelligence artificielle (IA) sophistiqués sur la créativité humaine, le jugement et la prise de décision. Ces outils ont été décrits comme des décimateurs d'emplois et des accélérateurs de productivité. Les scientifiques et les développeurs examinent actuellement les capacités et les faiblesses de ces outils, mais il y a également des questions importantes sur leur impact sur nos propres compétences et capacités.

Ces outils peuvent stimuler la créativité en offrant une large gamme de possibilités et en proposant des idées alternatives. Cependant, cela peut également conduire à la production de clichés plutôt qu'à des idées novatrices et originales. Les experts s'interrogent également sur l'influence sociale de ces outils et sur la façon dont les interactions avec l'IA peuvent modifier les normes sociales. |

| | |

| | | | 🗣 CONSTRUISONS CETTE LETTRE ENSEMBLE ! | | |

| | | 🤔 PARTAGEONS NOS REFLEXIONS | |

| |

Geneviève, qui est enseignante, continue ses expérimentations avec ChatGPT qu'elle utilise comme un partenaire :

| "Je trouve que les sessions de chat-GPT les plus enrichissantes sont celles où on a le sentiment de discuter avec un collègue qui peut pointer les forces et les limites de ce que l'on écrit, d'autant plus qu'il n'y a aucun affect ou jugement. On peut déposer ses idées sans crainte de ce qu'il peut penser et c'est libérateur, par certains aspects, on peut même risquer des idées, réflexions dont on n'est pas très sûr. Mais par moments, j'avais l'impression que ce collègue avait un peu la maladie d'Alzheimer !" |

Pierre, producteur de films et de vidéos, teste lui aussi ChatGPT et ça change son métier :

| "Concernant l'IA, c'est juste dingue ce qui est en train de se passer. Mes deux sociétés sont vraiment impactées. Arkonte (le studio 3D https://www.arkonte-studio.com/) surtout et puis Isegoria plus doucement. Chez Arkonte on doit trouver une nouvelle fonctionnalité par jour à l'IA (image ou code)... ça va tellement vite c'est presque effrayant. Il y a 15 jours je disais que c'était comme en 2007 quand les RS ont débarqué dans nos vies... Mais en fait non... C'est beaucoup plus fort car ça change directement nos outils de productivité, ça transforme notre manière de travailler et de réfléchir. En l'espace d'un mois on a vraiment changé sur certaines approches, je n'imagine même pas à quel point on aura vraiment changé nos manières de travailler dans 6 mois. On a longtemps parlé de l'homme augmenté à propos du transhumanisme... On y est ! Mais pas comme on le pensait il y a 2 ans, pas d'implant juste des prompts. Et la fracture à venir entre ceux qui vont dès maintenant se familiariser et travailler avec le l'IA et les autres va être énorme." |

Aude revient sur l'article concernant les effets bénéfiques des arbres sur la criminalité des quartiers. Elle se demande s'il n'y a pas un biais dans l'analyse :

| "Je m'interroge sur les conclusions tacites qui sont tirées dans [l'] article. Mon intuition me dit que les arbres n'ont pas un pouvoir aussi grand mais plutôt que les plus riches (ou simplement, pas les moins pauvres) s'installent dans des quartiers arborés. Est-ce que le sujet a vraiment été traité dans l'étude afin de déterminer ce qui est du côté des causes et ce qui est du côté des conséquences ?

J'ai bien connaissance de la biophilie donc bien sûr je sais que la proximité avec les arbres est bénéfique. Mais bon, de là à inverser à elle toute seule une courbe de dépression ou de criminalité ça demande un peu plus de matière pour me convaincre. " | | "Ce n'est pas parce que les arbres sont la cause de la prospérité, mais parce que les communautés prospères sont plus susceptibles d'investir dans l'aménagement paysager et la couverture arborée, et de disposer des fonds nécessaires à cet effet." |

Sabine revient sur le silence que j'évoquais dans ma dernière lettre, et qu'elle ne peut plus expérimenter :

| "Quelle expérience que le silence ! Je ne connaissais pas cette fête balinaise et ça me semble une expérience incroyable ! Expérimenter le silence et l’obscurité ! Waouh ! Dans nos sociétés qui vont trop vite et trop bruyantes nous n’en savons plus mettre sur pause. Je n’ai pas entendu le silence depuis 4 ans 1/2 à cause d’acouphènes permanents et parfois je me demande ce que cela fait de l’entendre ! Peut être qu’il me faudrait un dragon pour faire peur à mes acouphènes !" |

|

| |

| | | | 🤗 PARTAGE OU ABONNE-TOI ! | | |

| | 🥳 Vous avez été 9742 à avoir lu la dernière lettre (soit 114 de plus que l'édition précédente). Sur un total de 20171 abonnés francophones ! Merci ! |

| |

| |

| |

|

🦾 Si tu veux découvrir la version pro de Flint, c'est ici.

|

| |

| 🤫 Je te souhaite un beau dimanche de... pause ! Si tu veux partager tes réflexions, réponds à cette lettre ou écris-moi à benoit @ flint.media !

|

| 💛 Benoît |

| |

|

| | | | Cette lettre a été réalisée par Flint Business. Flint utilise l'intelligence artificielle pour te permettre de créer des newsletters intelligentes en moins de 5 minutes afin de partager les meilleurs contenus d'information trouvés sur Internet, et d'y apporter (si tu veux) ton expertise. Tu peux tester ce nouveau service pendant 30 jours en cliquant sur le logo Flint ci-dessus ! ☝️ | |

| |